Infox : Le CSA appelle les plateformes à la transparence

Le Conseil supérieur de l’audiovisuel (CSA) présentait ce mardi le deuxième bilan de l’application et de l’effectivité des mesures mises en œuvre par les plateformes pour lutter contre la diffusion de fausses informations, confiée au CSA par la loi du 22 décembre 2018 relative à la lutte contre la manipulation de l’information. 14 plateformes en ligne soumis au devoir de coopération — déclenché à partir de 5 millions de visiteurs uniques mensuels en France — ont déclaré au CSA les moyens mis en œuvre pour lutter contre la diffusion de fake news : Dailymotion, Facebook, Instagram, Wikipédia, Google Search, YouTube, LinkedIn, Microsoft Advertising, Bing, Jeuxvideo.com, Snapchat, Twitter, Doctissimo et Yahoo Search.

Le CSA — qui a remanié son organisation pour répondre à cette nouvelle compétence, en créant une direction des plateformes en février 2021, dirigée par Lucille Petit — recommande six types de mesures : un dispositif de signalement, la transparence des algorithmes, la promotion des contenus de presse et audiovisuels, la lutte contre la propagation massive de fausses informations, l’information des utilisateurs sur la promotion des contenus d’information promus, et l’éducation aux médias et à l’information et collaboration avec la recherche. « Ce n’est pas une régulation des contenus, mais des textes qui fixent des obligations aux acteurs de moyens pour lutter ces phénomènes. Le régulateur a une mission de supervision, de vérification, de contrôle, que ces obligations sont effectivement mises en oeuvre », a déclaré mardi matin Roch-Olivier Maistre, président du CSA.

Le CSA demande plus de coopération

« On est là pour faire bouger les lignes. Ce qu’on constate, c’est que les choses ont progressé, il faut encore aller un petit peu plus loin », a-t-il ajouté, avant de laisser Benoît Loutrel, membre du CSA (ex Arcep, Google), présenter les préconisations du CSA. « Il faut organiser la manière d’appréhender cette puissance qu’elles ont sur l’information et faire des incitations pour qu’elles modifient leurs pratiques, qu’elles se comportent de manière plus citoyenne, responsable, qu’elles participent de manière démocratique à l’atteinte d’objectifs d’intérêt public », a indiqué Benoît Loutrel.

« S’agissant des algorithmes, de recommandation ou de modération, cette année les informations sont plus nombreuses et plus pertinentes, néanmoins elles restent insuffisantes pour évaluer le rôle de ces systèmes dans la lutte contre la manipulation de l’information », a précisé Lucille Petit. Le niveau des réponses demeure très hétérogène, « Verizon Media se distinguant par une déclaration particulièrement étique » (maigre, ndlr), a indiqué le CSA, qui appelle à plus de coopération sur certains sujets majeurs tels que le fonctionnement des systèmes algorithmiques de recommandation et de modération ou la lutte contre la manipulation de l’information dans le domaine publicitaire. Le CSA explique que les déclarations attestent des efforts fournis par les opérateurs « face à une surabondance de fausses informations liée à la crise sanitaire », et le Conseil remarque également la prise en compte de « quelques-unes des recommandations » qu’il a formulées l’année passée et « encourage les plateformes à continuer en ce sens ».

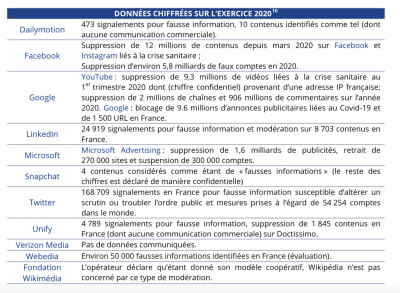

Le Conseil appelle les opérateurs des plateformes à communiquer davantage de données chiffrées communiquées concernant le nombre de contenus modérés/supprimés, « données globalement manquantes dans les déclarations ». Il pointe une hétérogénéité dans l’accessibilité et la visibilité du dispositif de signalement, une information insuffisante sur les voies de recours, et un accroissement du rôle des outils algorithmiques de modération. Le CSA — qui rend public les déclarations des plateformes, disponibles sur son site — a ensuite décliné un ensemble de nouvelles préconisations. Sur le dispositif de signalement, le CSA préconise une amélioration de leur visibilité, une meilleure information pour les auteurs de signalement et les utilisateurs ayant publié un contenu signalé de l’avancée des procédures de traitement, et le maintien d’une intervention humaine dans le processus de décision.

Concernant la transparence des algorithmes, le Conseil préconise de proposer aux utilisateurs des fonctionnalités leur permettant de comprendre, « si possible de manière personnalisée et contextuelle », les effets des systèmes algorithmiques de recommandation et de modération ; et de déclarer « tout élément donnant à voir comment la lutte contre les biais est concrètement mise en œuvre sur leurs services ». Du côté de la promotion des contenus presse et audiovisuels, le CSA appelle au renforcement des collaborations pour la mise en avant d’informations vérifiées, à de nouvelles mesures relatives à l’identification des sources de contenus et à des initiatives pour valoriser le fact-checking. Le CSA souhaite également, dans la lutte contre les comptes propageant massivement des fausses informations, une meilleure catégorisation des pratiques de manipulation et de nouveaux moyens de détection. Le Conseil préconise d'informer davantage les utilisateurs sur les pratiques coordonnées d’influence et les risques qui en découlent, « tout particulièrement en période électorale » ; et de faire preuve de davantage de transparence, à tout le moins à l’égard du régulateur, sur les recettes publicitaires potentielles générées par les comptes propageant massivement de fausses informations.

La transparence pour les utilisateurs

En matière de communications commerciales, le CSA demande de rendre les politiques publicitaires accessibles en français et faire en sorte qu’elles comportent une partie relative à la manipulation de l’information ; de mettre en place des outils faciles d’accès et d’utilisation « permettant à l’utilisateur de comprendre pourquoi il a été ciblé dans une situation donnée et de paramétrer ses préférences publicitaires » ; et de mettre à disposition du Conseil des données chiffrées « permettant de saisir l’ampleur des liens financiers entre manipulation de l’information et communications commerciales sur les plateformes ».

Quant à l’éducation aux médias, le CSA préconise d’évaluer l’impact sur le comportement des utilisateurs des actions en matière d’éducation aux médias et à l’information et en rendre compte au public et au régulateur ; et d’intensifier les collaborations avec le monde de la recherche, notamment en mettant en œuvre les conditions permettant la mise à disposition et l’exploitation des données à grande échelle. Enfin, sur la transparence en général, le conseil demande aux plateformes de fournir de manière proactive aux utilisateurs, si possible de manière personnalisée et contextuelle, des explications claires et accessibles sur les mesures mises en œuvre face aux risques liés à la manipulation de l’information ; et de faire preuve de plus de transparence vis-à-vis du public en fournissant davantage de précisions chiffrées et d’éléments contextualisés, notamment dans les déclarations, et communiquer au Conseil toutes les informations, « fussent-elles confidentielles », permettant de mieux comprendre les mesures prises et leur impact.